request entity large 413

has been blocked by CORS policy: The request client is not a secure context and the resource is ...

该报错原因为:Chrome浏览器禁止外部请求访问本地,被CORS策略阻止解决方案:1、打开chrome的设置: chrome://flags/#block-insecure-private-network-requests2、将 Block insecure private network requ ......

elementUI中upload自定义上传行为 http-request属性

需求是上传一个xlsx后台处理完再返回xlsx流upload 请求需要添加responseType: 'blob' 属性所有要扩展一下 若依项目扩展elementUI中upload自定义上传行为 http-request属性 ``` 将文件拖到此处,或点击上传 仅允许导入xls、xlsx格式文件。 ......

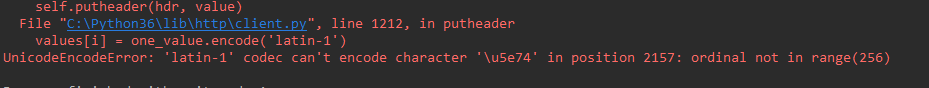

解决python中requests请求时报错:UnicodeEncodeError: ‘latin-1‘ codec can‘t encode character

当request请求中,带有中文,可能引发报错:  UnicodeEncodeError: 'latin-1' c ......

requests 请求网页乱码

一般情况下,每个网页有自己的编码,在使用 requests 请求对应网页时,如果遇到中文编码的问题,大多数情况下直接显式指定 encoding 就可以了,但是今天遇到一个网站,还真是怎么指定都不行:https://www.medchemexpress.cn/ 以下所列的参考文档可能能解决编码问题,所 ......

configure: error: udev support requested but libudev header not installed

./configure --host=arm-none-linux-gnueabi 错误提示:configure: error: udev support requested but libudev header not installed 解决办法 --disable-udev 取消对libude ......

高速——request请求

为防止服务器响应缓慢,导致客服端处理异常,requests请求大多设置 timeout 参数。Requests中timeout不设置默认值。 **读取超时**是没有默认值的,如果不设置,程序将一直处于等待状态。我们的爬虫经常卡死又没有任何的报错信息,原因就在这里了。 ## Timeout 类型: 超 ......

Scrapy_Request对象Cookie的演示

Cookie的使用 import scrapy class CookieSpider(scrapy.Spider): name = "爬虫名" allowed_domains = ["域名.com"] start_urls = ["url地址"] def start_requests(self): ......

Scrapy_Request对象dont_filter演示

import scrapy class BaiduSpider(scrapy.Spider): name = "baidu" allowed_domains = ["baidu.com"] start_urls = ["https://baidu.com"] def parse(self, resp ......

Scrapy_Request对象meta演示

request里面的meta 的使用 import scrapy class Xs2Spider(scrapy.Spider): name = "爬虫名" allowed_domains = ["域名"] start_urls = ["url地址"] def parse(self, response ......

Invalid character found in the request target [/api/hsFile/download?filePath=E:\\%E4%B8%B4%E6%97%B6%E6%96%87%E4%BB%B6&fileName=aaaaa.xlsx]. The valid characters are defined in RFC 7230 and RFC 3986

java.lang.IllegalArgumentException: Invalid character found in the request target [/api/hsFile/download?filePath=E:\\%E4%B8%B4%E6%97%B6%E6%96%87%E4%BB ......

requests Python中最好用的网络请求工具 基础速记+最佳实践

requests 模块是写python脚本使用频率最高的模块之一。很多人写python第一个使用的模块就是requests,因为它可以做网络爬虫。不仅写爬虫方便,在日常的开发中更是少不了requests的使用。如调用后端接口,上传文件,查询数据库等。本篇详细介绍requests的使用。 ......

Scrapy 中 Request 的使用

爬虫中请求与响应是最常见的操作,Request对象在爬虫程序中生成并传递到下载器中,后者执行请求并返回一个Response对象 一个Request对象表示一个HTTP请求,它通常是在爬虫生成,并由下载执行,从而生成Response 参数 url(string) - 此请求的网址 callback(c ......

DTO 与 Entity的区别

entity:实体类,与数据库中的字段保持一致,用于表示某实体中所包含的所有属性。 DTO:数据传输对象,用于数据传输,根据业务需求来决定包含哪些属性。根据实际业务需求将数据返回给前端,避免造成不必要的资源浪费和数据暴露,造成不必要的安全问题。 ......

pycharm中的gihub copilot中报错Sign in failed. Reason: Request signInInitiate failed with message: getaddri无法使用问题

pycharm中的gihub copilot中报错Sign in failed. Reason: Request signInInitiate failed with message: getaddri无法使用问题 解决方法:idea打开我们的插件 settings-plugins-找到插件,点击h ......

Automatic quality of generated text Evaluation for Large Language Models,针对大模型生成结果的自动化评测研究

Automatic quality of generated text Evaluation for Large Language Models,针对大模型生成结果的自动化评测研究 ......

Row size too large. The maximum row size for the used table type

> # 原文链接:https://blog.csdn.net/yyj108317/article/details/108756493 在一段自动创建mysql表的[sql语句](https://so.csdn.net/so/search?q=sql语句&spm=1001.2101.3001.7020 ......

Proj. CAR Paper Reading: CodeBPE: Investigating Subtokenization Options for Large Language Model Pretraining on Source Code

## Abstract 本文:探索LLM在source code上pretrain时的subtokenization效果。 subtokenization: split long tokens into smaller subtokens, in order to ensure the relati ......

【requests】接口请求报错Unsupported Media Type

一、场景 由于做接口自动化测试, 根据接口文档,编写接口用例,报错415, Unsupported Media Type 二、HTTP请求的媒体类型 以text开头的媒体格式类型: text/html: HTML格式。 text/plain:纯文本格式。 text/xml: XML格式。 以imag ......

Springboot 框架中的Entity,Dao,Service,Controller的关系

* SpringBoot框架中的Entity,DAO,Service,Controller层的关系 ### 参考: * https://blog.csdn.net/weixin_44532671/article/details/117914161 * https://blog.csdn.net/m0 ......

欧姆龙cp1h带两个nc413模块,总共十个轴控制程序案例,还有DD马达控制,内带详细注释,包含nc413所有参数设

欧姆龙cp1h带两个nc413模块,总共十个轴控制程序案例,还有DD马达控制,内带详细注释,包含nc413所有参数设置,写入,定位控制,附带昆仑通泰触摸屏程序和dd马达程序YID:349608416494704 ......

使用requests和BeautifulSoup对北京市政百姓信件进行爬取

一开始爬取的时候,没有加上请求头,所有导致会出现创宇盾进行防护,加上请求头即可 还有问题就是,这个网址的页号和网址是无关的,所以采用网上说的改变url来改变页号进行爬取是不可行的,使用 for page in range(start_page, end_page + 1): url = url.fo ......

python requests库的超时设置

在 requests 库中, timeout 参数其实是一个比较复杂的概念。如果你直接把一个数字作为 timeout 参数的值,那么这个数字代表的是连接(connection)和读取(read)两个阶段的总时间,而不是各自的时间。换句话说,如果你设置 timeout=5,那么连接和读取阶段的总时间就 ......

The remote SSH server rejected X11 forwarding request.“远程SSH服务器拒绝X11转发请求

启动kkFileView后弹出提醒无法正常访问服务器, 重启服务器时,需要安装出现如下提醒 方法一、 X11 forwarding依赖xorg-x11-xauth软件包,需要先安装xorg-x11-xauth软件包。 1. 使用Xshell执行下面代码 [root@VM-4-11-centos ~] ......

QA|requests接口请求失败而postman请求成功原因排查|Requests

requests接口请求失败而postman请求成功原因 代码如下 1 def ihrm_login(login_data, url1): 2 """login_data:入参""" 3 res = requests.post(url=url1, data=login_data) 4 # print ......